經過了長達3年的過程,歐盟AI法案終於完成立法程序。做為全球首個涵蓋開發與應用的法律框架,其法案可能成為其他國家制訂相關法規的參考標準,進而影響全球AI治理。該法案強調AI系統的風險管理、倫理考量、應用AI技術的安全性,與透明度,並要求對高風險AI進行嚴格的審查與監管,這些作法預料將促使其他國家在制訂AI政策時也重視相同的問題。

由於歐盟市場的重要性,非歐盟國家公司也必須遵循此法案的要求,以便在歐洲市場運營,因此企業在開發AI時必須考慮更廣泛的法遵與合規要求。隨著AI法案的實施進程,歐盟可能會透過加強與其他國家的合作,以及在公、私層面促進AI治理方面的國際對話和合作,形成更全面和協調的(全球)AI治理框架。

以出口為導向的臺灣企業,若是向歐盟市場提供AI產品或服務,可能需要遵循法案的各項要求,包括風險管理、安全性、透明度和數據治理在內的嚴格合規要求。一方面可能會增加企業的運營成本,並需要進行額外的合規培訓和技術調整,一方面要在AI技術的研發上更加注重倫理和法遵合規。

本系列為了協助臺灣產業欲做因應準備,歐盟AI法案可能帶來的影響,擬針對歐盟AI法案的具體要求、合規管理、AI技術的開發和應用策略以及監測政策變化等議題進行探索與介紹。期待協助臺灣企業能應對歐盟AI法案帶來的挑戰,同時抓住機遇,提升在全球市場的地位。

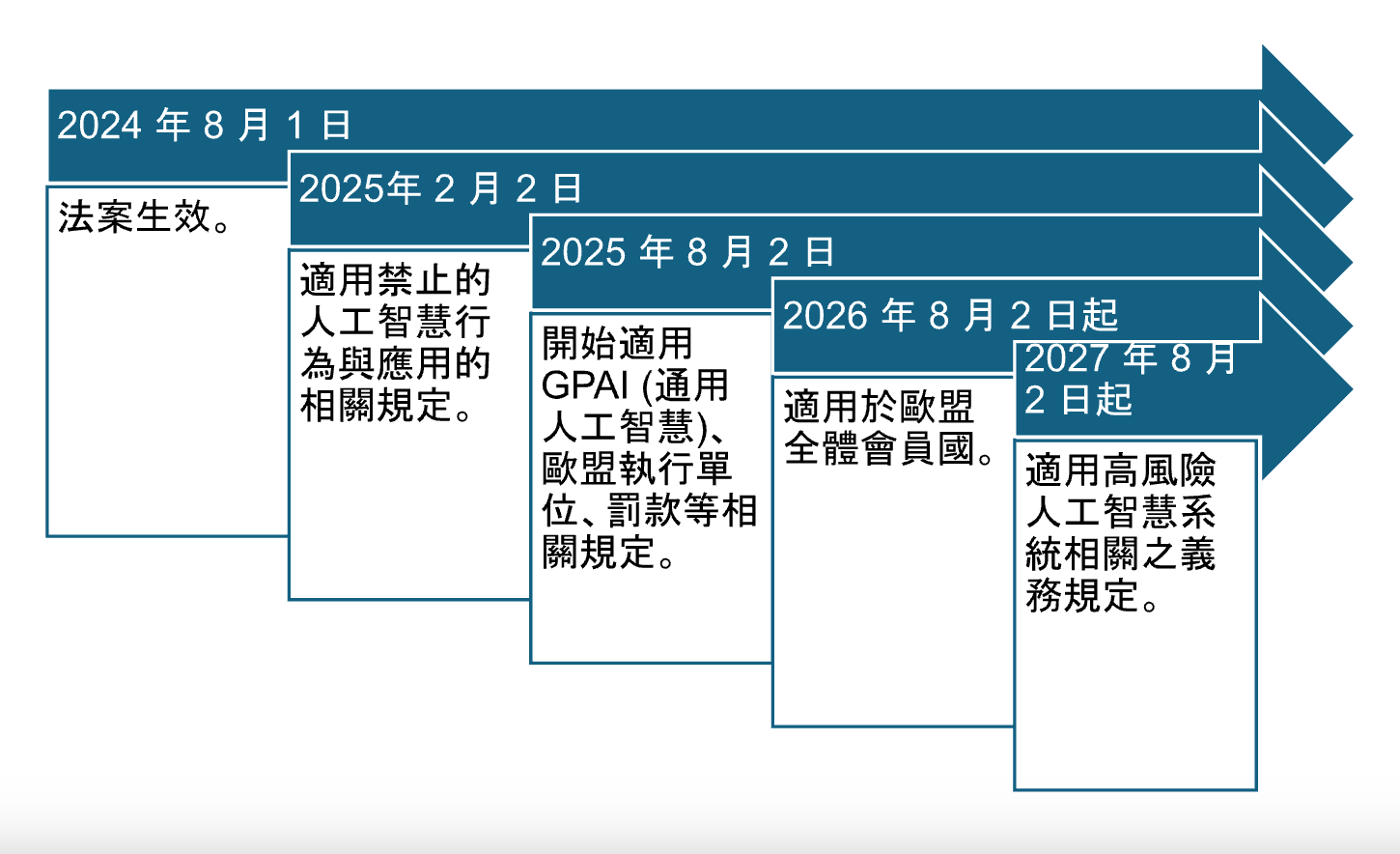

歐盟人工智慧法案影響時間軸

歐盟執委會於 2021年 4月提出歐盟 AI法案,該法案係全球首部針對 AI 之全面性法規。此處先以時間軸的方式梳理歐盟AI法案後續實施進程的幾個關鍵里程碑,方便讀者了解及因應準備。

- 2024 年 8 月 1 日法案生效。

- 2025年 2 月 2 日適用禁止的人工智慧行為與應用的相關規定。

- 2025 年 8 月 2 日開始適用GPAI (通用人工智慧)、歐盟執行單位、罰款等相關規定。

- 2026 年 8 月 2 日起適用於歐盟全體會員國。

- 2027 年 8 月 2 日起適用高風險人工智慧系統相關之義務規定。

歐盟AI法案的 4 組關鍵密碼:13, 113, 4, 3

13 和 113:歐盟 AI 法案共有 13 章、 113 條規定。重點摘要如下:依人工智慧的風險進行分類、多數義務由高風險人工智慧系統的提供者(開發商)承擔、《使用者》是以專業身分部署人工智慧系統的自然人或法人,而不是受影響的最終使用者,以及對”通用人工智慧(GPAI)”之規範。

4: 代表人工智慧區分四個風險等級,包含禁止不可接受的風險、需要監管的高風險人工智慧系統、有限的人工智慧系統和不受監管的低風險。

3: 代表三大罰則。其中1).不遵守「禁止不可接受的風險之人工智慧應用」,最高可以處分3500萬歐元或是全球年營收的7%,以其較高者為準之罰鍰。2). 違反人工智慧治理和透明度要求,可以處分1500萬歐元之罰鍰;3). 不遵守任何其他要求或義務,可能會導致高達 750 萬歐元或全球營業額 1% ,以其較高者為準之罰鍰。這種罰款結構旨在藉由嚴重的財務懲罰,來確保對企業具有足夠的威懾力,促使各類企業都嚴格遵守法規,以避免高額的罰款。

高風險人工智慧系統分類規則

本文先就高風險AI應用的要求進行探討,其他重點將於隨後的文章中分批討論和解析因應之道。

依據歐盟人工智慧法案第六條:高風險人工智慧系統分類規則,所謂的高風險人工智慧系統是在用作產品的安全組件,或人工智慧系統本身,屬於附件一和附件三所列歐盟調和立法所涵蓋的產品。

附件一包含哪些產品呢?包含機械、玩具、休閒遊艇、電梯、防爆性設備和保護系統、無線電設備、壓力設備、個人防護裝備、燃燒器具、醫療器材和體外診斷醫療器材。簡單來說,就是跟進口到歐盟市場需具備的 CE mark 安全驗證品項大致相同,只是再加上 AI 裝置和應用。附件三則是包含生物辨識、關鍵基礎設施、教育訓練、就業和員工管理、公共福祉服務、移民和邊境管制等應用。

參考行政院國情簡介(113/3/28)經濟部提供的進出口貿易量,112 年我國主要出口產品中,最大出口項目為電子零組件,占整體出口比重 41.3%;其次為資通與視聽產品,比重為 19.3%。第 3 大為基本金屬及其製品,比重為 6.6%。

因此附件一和附件三所規範的品項跟我國前兩大出口產品領域有高度的重疊性,相對於當下大家所關注的 CBAM (碳邊境關稅)影響更甚,廠商有必要超前部署。並且是從產品的研發設計、生產製造、銷售和部署、後續的升級和維運等整個全生命周期觀點,都有必要考慮到如何滿足高風險 AI 系統的嚴格要求。

高風險 AI 系統要求

高風險 AI 系統有哪些法規要求呢?包含合規性要求、風險管理、資料治理、技術文件和紀錄保存、資訊透明度、人工監督、準確性、系統穩健性和網路安全等,這些都是國際間對可信賴 AI 基本且具共識的要求。

然而要如何確保所提供的高風險 AI 系統可以滿足這些要求?

歐盟人工智慧法案也明文規定要求需要建立”品質管理系統”,藉以建立系統化制度化的管理,確保文件和記錄的自動保存以及採取必要的矯正措施和提供資訊的義務。不僅是是要建立和維持一套有效的管理系統,同時也要求進行1).內部控制和合規性評估程序、以及2).品質管理系統和 AI 技術規範文件的符合性評估,正好與國際標準組織所推出的 ISO 42001 人工智慧管理系統標準相互為用。

可以想像的,以出口為導向的臺灣產業,除了致力於AI技術的開發應用創造持續領先的競爭力外,也需要同時建立好一套跟國際接軌、符合法規要求的管理系統,透過這些制度、以及相關的AI技術規範(例如ISO/IEC 5259 Part 1, 2, 3, 4, 5 用於分析和機器學習 (ML) 的數據品質等超過10項規範) 用來確保所開發的AI應用可以滿足「可信賴AI」所訴求的各項條件。

隨後我們再用其他篇幅,探討產業的因應之道。