機器學習在過去十年飛速發展,正在改變世界,包含臉部辨識、自動駕駛等應用,都看得到機器學習的蹤跡。自駕車前景看好,眾多車廠積極投入研發,然而車輛涉及人身安全,一旦系統受到惡意攻擊,對於生命與安全的影響非同小可,自駕車的資安是不可忽視的議題。

香港城市大學計算機科學系教授王聰認為,自駕車技術還需要很長的時間去探索,隨著新的攻擊不斷出現,就會找出新的防守方法,一來一往才能讓自駕車資訊安全網更加穩固,與其說是軍備競賽,不如將這個過程定義為攻防演練。以下為王聰在鴻海研究院 NExT Forum 演講摘要。

機器學習模型的不完美 成為惡意攻擊的目標

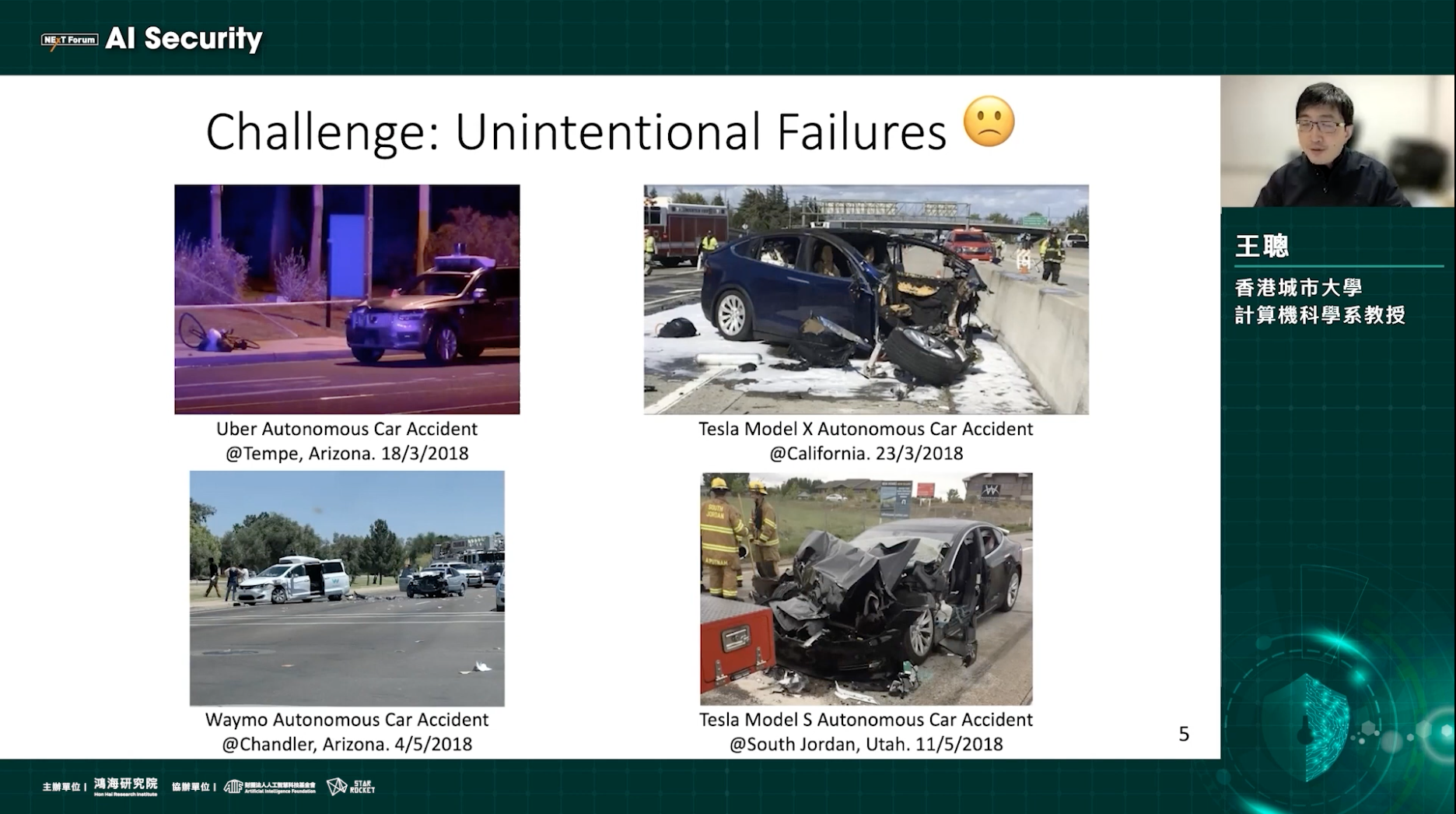

事實上,自駕車的藍圖非常廣闊,包括自駕系統、數據、光感應、製造等領域,儘管許多科技大廠投入,但是仍然不時出現事故,這可以將其歸類為「非預期失誤」,可能因為光線、天氣等因素,顯露出機器學習模型在決策中的誤判。此外,也可能因為對於模型的訓練不夠廣泛,會發生因為不足以判斷躺在路上的大卡車其實是個障礙,而車輛衝撞的事故。

既然機器學習模型不完美,攻擊者也可能利用這個特性,放大它的缺陷,使得機器更容易犯錯,這就是「惡意攻擊」。舉一個最常見的例子,路上的「停止號誌」如果被攻擊者放上人眼不可區分的雜訊,雖然肉眼看起來正常,但是自駕車的攝影機識別出來,卻變成「限速45公里」的號誌,若是發生在真實道路情境,後果相當危險。

圖片以外,語音辨識也可以有類似的干擾,人耳聽起來一樣的一段語音,加入惡意擾動的雜訊可能就會透過語音助理打開瀏覽器,並且開啟植入惡意程式的網頁,進而產生攻擊。另一個案例發生在自駕車變換車道,車輛跟著白線行駛,如果在地上出現一個惡意補丁,導致車輛自動移往別的車道,跟其他車輛相撞,產生事故。

機器學習的各個流程 都可能變成攻擊對象?

前面提到的例子,都是有關於機器學習模型所受到的對抗式攻擊,以至於做出錯誤的決策。如果從更全面的角度來看,一個完整的機器學習系統,包含四個流程:感測(Sensor)、資料預處理(Data Preprocessing)、機器學習模型(Machine Learning Model)、決策(Decision Output)。透過感測器去接收物理世界的訊息,拿到這些資料後,透過資料前處理的步驟,準備這些原始資料變成特徵集,最後才能讓機器學習模型做決策。

若是前面兩個步驟就受到攻擊,會發生什麼事情?根據這兩年的研究,在資料前處理的階段,圖片來自於自駕車的鏡頭,前處理的階段就是要將它從比較大的圖片,降低採樣頻率(Downsampling)變成小資料,這個過程是為了準備原始資料,讓模型在決策的時候更方便。這個環節會怎麼出錯?也許在原始資料上加上一些擾動,導致做完預處理之後,導致後面的小資料跟原始資料完全不相關。

感測(Sensor)也很容易被攻擊,這個步驟主要是捕捉物理世界的資料,放進數位世界,例如車輛裡的語音系統,透過人耳聽不到的聲音指令,就可以將帶有攻擊的指令輸入到機器裡,在人沒有察覺的情況下,而且車輛正在自動駕駛的過程中,也會產生安全疑慮。

自駕車仍需學界業界共同合作

自駕車在發展的過程中,所面臨的缺陷仍然非常多,然而好消息是,已經有許多國家開始從法規的層面逐漸落實佈署,這些都可以讓相應技術的開展和創新得到好的規範,在這個框架之下,需要學界和業界共同合作,尤其在資安的議題上,才能確保上路後是安全無虞。

長遠來看,或許有人說自駕車的資安問題像是軍備競賽,但王聰認為,這更像是攻防演練,不斷有新的攻擊,但同時也產生相應的防守策略,兩相抗衡之下,終究會愈趨完備。此外,自駕車的安全不僅需要專業的製造設計工程師,也需要AI開發者來教育這些自駕車,使它們更有智慧。總而言之,推進自駕車還需要結合不同專家的專長,探索出未來可能。

精彩演講內容: